Opera анонсировала возможность загрузки и локального использования LLM. Пользователям предлагается более 150 моделей, включая Llama, Gemma и Vicuna. Каждая из них весит более 2 ГБ.

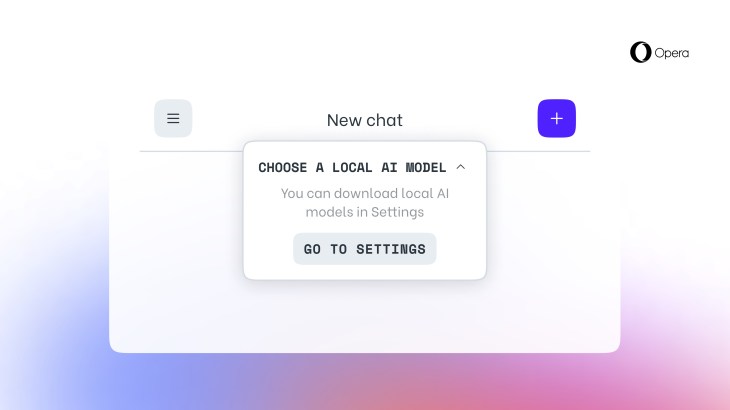

Компания-разработчик браузера Opera объявила о новой возможности для пользователей — загрузке и использовании LLM локально на компьютерах. Эта функция, предлагающая более 150 моделей из более чем 50 семейств, впервые представлена для пользователей Opera One.

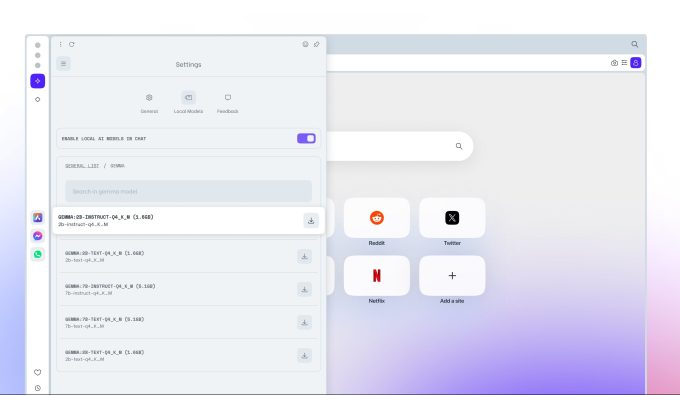

На данный момент все модели, доступные для использования, являются частью библиотеки Ollama. Среди них: Llama от Meta*, Gemma от Google и Vicuna. Однако в будущем планируется расширение доступных источников.

Стоит отметить, что каждая модель занимает более 2 ГБ места на локальном диске, поэтому пользователи должны учитывать свободное пространство на своих устройствах, чтобы избежать проблем с хранением данных.

Ян Стандал, вице-президент Opera, подчеркнул, что это первый случай, когда браузер открывает доступ к локальным LLM от различных производителей. Он также отметил, что размер моделей может уменьшаться по мере их специализации для выполнения конкретных задач.

С 2023 года Opera активно экспериментирует с функциями на основе ИИ. В мае 2023 года был запущен помощник Aria, расположенный на боковой панели, а в августе была представлена его версия для iOS. В 2024 году Opera объявила о создании браузера на базе ИИ с собственным движком для iOS.

* Meta признана в России экстремистской организацией и запрещена.