Представьте ситуацию: вечер, родители получают от вас голосовое сообщение, полное паники, в котором говорится, что вы попали в беду, у вас украли бумажник, и необходимо срочно перевести деньги, чтобы смогли добраться домой. Голос в сообщении звучит так реально и безошибочно принадлежит их ребенку, но это не так.

Клонировать голос инструментами искусственного интеллекта невероятно просто, и это может быть использовано для манипулирования членами семьи и близкими. В этой статье рассмотрим новый метод мошенничества с голосовыми сообщениями и как от этого защититься.

Как работает мошенничество с клонированием голоса ИИ-инструментами?

Вымогатели используют нейросети для подделки голосовых сообщений в Telegram. Сначала аккаунт взламывают — а потом делают нарезку из голосовых, чтобы составить из них просьбу одолжить денег. После эта нарезка отправляется в личные чаты.

Клонирование голоса нейросетями позволяет создавать невероятно реалистичные цифровые копии голоса человека. Эта техника работает с помощью инструментов ИИ, таких как ElevenLabs. Инструмент может воспроизводить эмоции, интонации, даже страх и прочие нюансы.

Для создания голосового клона ИИ требуется лишь небольшой образец голоса — часто всего минута или меньше. Образцы голосов берут не только из личной переписки при взломе аккаунта, но и из публичных постов в социальных сетях, что делает видеоблогеров особенно уязвимыми.

После того как мошенники клонируют образец голоса, они используют преобразование текста в речь или даже речь в реальном времени для создания фальшивых звонков и голосовых сообщений.

Получив доступ к социальным сетям жертвы и собрав воедино ее личные данные, мошенник создает правдоподобный сценарий. Это может быть госпитализация, арест, кража, похищение — все, что вызывает страх. Затем клонированный голос используется для манипулирования членами семьи, чтобы заставить их поверить в то, что близкий человек находится в серьезной беде.

Реалистичность голоса и эмоции в сочетании с шоком и срочностью просьбы могут перебороть скептицизм, что приведет к поспешным решениям перевести деньги или предоставить конфиденциальную информацию.

Как и большинство мошенничеств, направленных на семью и друзей, клонирование голоса ИИ-инструментами эффективно, так как использует личные связи. Паника при получении сигнала бедствия от близкого человека может быстро затуманить рассудок и привести к необдуманным решениям.

Основные признаки мошенничества в голосовых сообщениях

Поначалу может показаться, что распознать ложное голосовое сообщение сложно, но если проявите бдительность, то легко заметите некоторые общие элементы. Несмотря на свою изощренность, мошенничество с голосовыми сообщениями может проявить себя с помощью ряда «красных флажков»:

- Неожиданные звонки: мошенники склонны выбирать нестандартное время для звонков, чтобы застать жертву врасплох.

- Срочность: мошенник будет убеждать вас, что произойдет что-то ужасное, если не предпринять немедленных действий. Это еще один психологический трюк — создать ощущение срочной необходимости для наших близких. Это чувство срочности оказывает давление, заставляя принять решение в отчаянии.

- Факты: мошенники не всегда знают всю историю отношений с объектом, поэтому обращайте внимание на несоответствия.

- Необычные просьбы: просьбы о переводе денег на зарубежные банковские счета или о платеже на криптовалютный кошелек — распространенная тактика.

Кстати, ИИ может имитировать тон и высоту голоса человека, но ему все равно не удастся воспроизвести диалекты. У каждого человека есть своя уникальная манера говорить, и только те, кто лично знаком с ним, могут знать об этих нюансах.

Что делать, если заподозрили мошенничество с клонированием голоса нейросетями

Если получили звонок или голосовое сообщение от близких, попавших в беду, сохраняйте спокойствие. Мошенники рассчитывают на то, что вы запаникуете и поддадитесь эмоциям, поскольку это повышает уязвимость перед их тактикой.

Если вам позвонили

Немедленно положите трубку. Не сообщайте никакой информации и не вступайте в контакт с мошенниками. Вместо этого перезвоните близкому человеку на известный номер, чтобы убедиться в подлинности сигнала бедствия. Дальнейший разговор с мошенниками может привести к тому, что ваш голос будет записан и клонирован.

Если вы получили голосовое сообщение

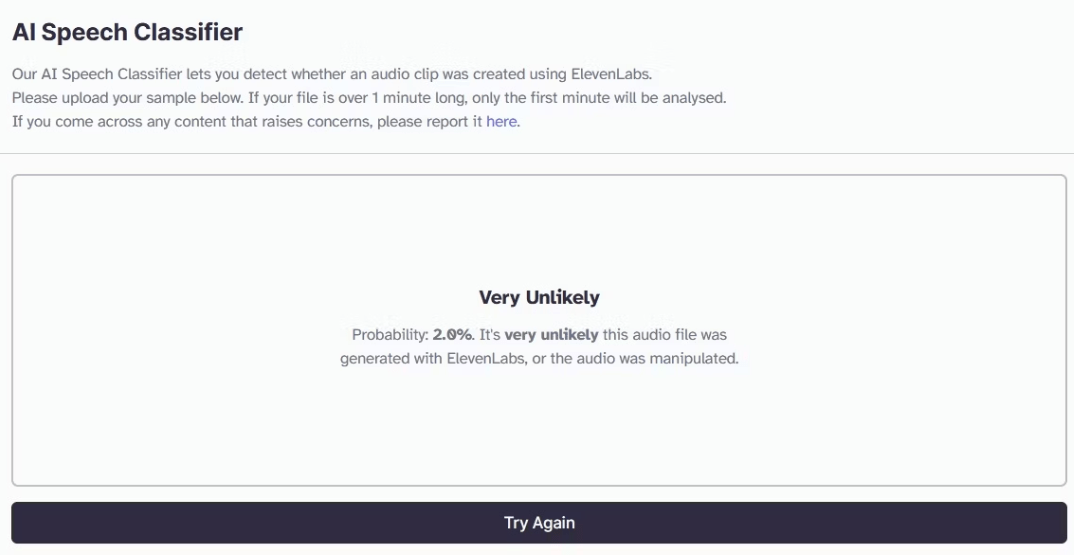

Если мошенники оставили голосовое сообщение, сохраните его на телефоне или ноутбуке. По этому образцу с помощью нейросетей можно определить, человеческий он или сгенерирован. Эти классификаторы речи работают так же, как детекторы текстов. Например, можно зайти на сайт ElevenLabs Speech Classifier, загрузить голосовое сообщение и нажать кнопку «Определить синтезированную речь».

В примере ниже сообщение было записано человеком и загружено в классификатор. Оно помечено как имеющее 2%-ную вероятность манипуляции.

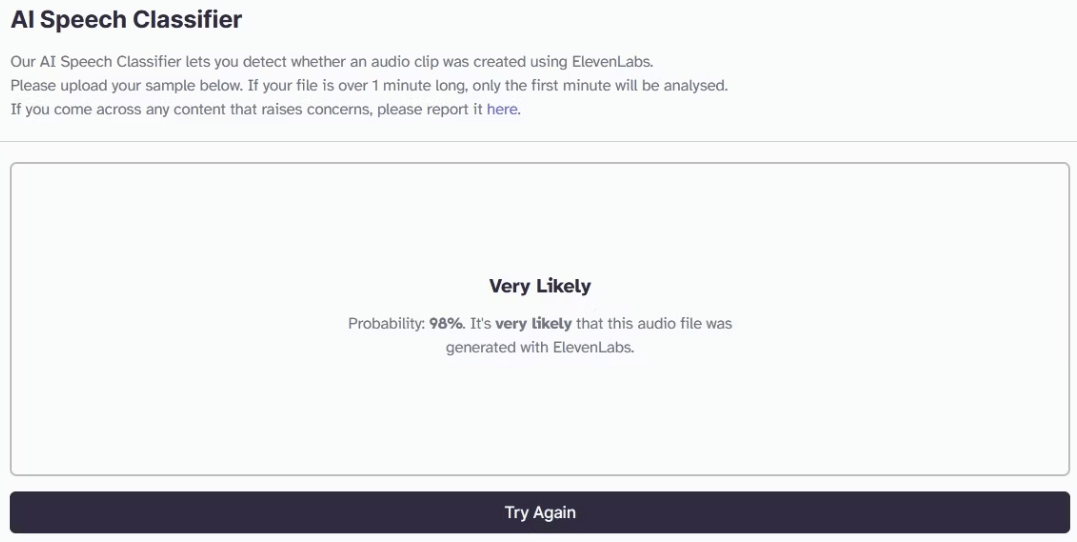

В следующем примере то же самое сообщение создано с помощью ИИ-инструмента клонирования голоса. Для человеческого уха они неразличимы. Однако детектор отметил, что с вероятностью 98% он сгенерирован ИИ.

Хотя на этот классификатор нельзя полагаться на 100%, он может подтвердить подозрения. А лучше всего — связаться с близким человеком по известному номеру.

Профилактика — лучшая защита от мошенников, клонирующих голоса с помощью нейросетей

Иногда лучшей защитой от высокотехнологичного мошенничества выступает низкотехнологичное решение.

Во-первых, выберите кодовое слово, известное только близким, семье и друзьям. В случае звонка использование этого пароля может стать надежным способом подтвердить личность звонящего.

Во-вторых, не выкладывайте свои видео и голосовые сообщения в социальных сетях в открытый доступ. Они могут послужить образцами для клонирования голоса. Это общая угроза для всех. Люди пользуются социальными сетями и делятся вещами, даже не подозревая, как это могут использовать против них. Немного осторожности и логического мышления не помешает.