Тайваньская компания Lite-On, специализирующаяся на платформах и решениях для облачной инфраструктуры, считает, что в связи с бумом центров обработки данных с ИИ необходимы более сложные технологии охлаждения. Традиционные системы воздушного охлаждения недостаточны.

Центры обработки данных искусственного интеллекта работают на мощных графических процессорах Nvidia или Advanced Micro Devices. Эти чипы могут выполнять параллельные вычислительные операции, необходимые для работы генеративных приложений ИИ, таких как ChatGPT OpenAI и Bard от Google. Но их требования к мощности постоянно возрастают. Следующее поколение B100 будет потреблять 1000 Вт электроэнергии на каждый чип. По мере роста энергопотребления чипа выделяемое тепло значительно возрастает. Температура напрямую влияет на производительность чипа и поэтому требует более сложных решений для охлаждения, чем раньше. Энергопотребление сервера искусственного интеллекта превышает предел технологий воздушного охлаждения в 300 Вт, что стимулирует спрос на более сложные и эффективные технологии охлаждения.

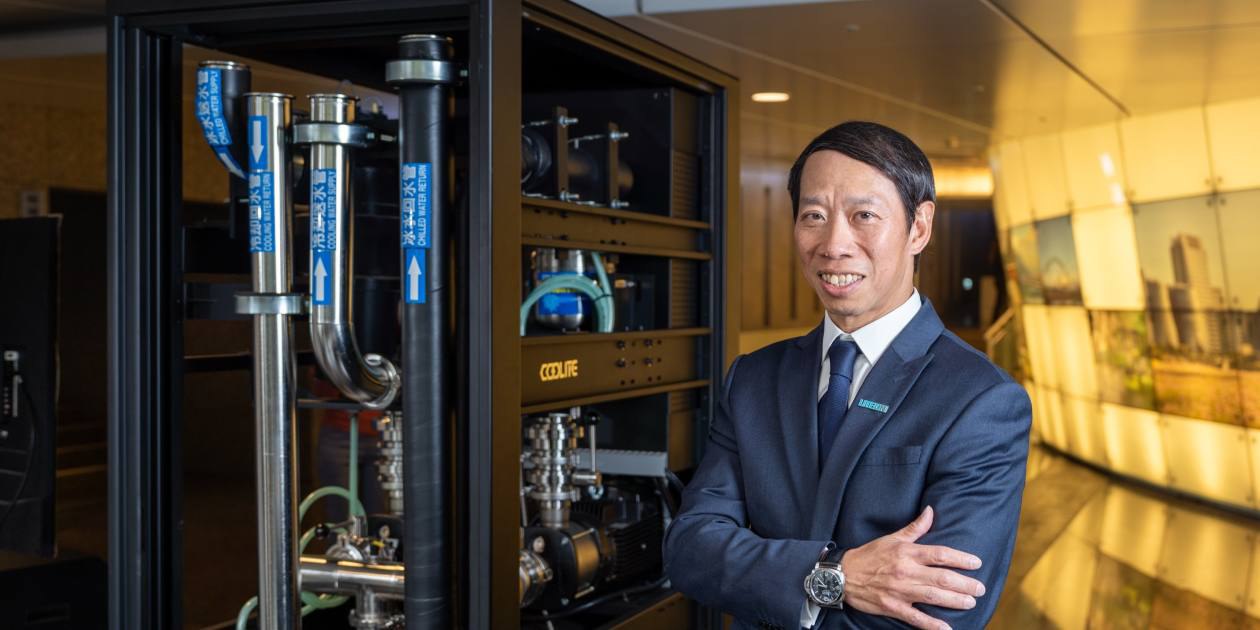

Lite-On, поставщик Apple, HP и Dell, делает ставку на свои системы жидкостного охлаждения Coolite, которые предназначены для борьбы с теплом, выделяемым центрами обработки данных ИИ. Жидкостное охлаждение включает в себя систему обтекания сервера водой для снижения температуры, и технологию погружения, при которой вся серверная стойка погружается в непроводящую жидкость.