Вершиной технологий индустриальной эпохи было овладение ядерной энергией. В 1930-е, когда открытия следовали одно за другим, физики старались выпускать статьи как можно быстрее. Энрико Ферми, обнаружив искусственную радиоактивность, наведенную нейтронами у легких элементов, опубликовал свое открытие в малоизвестном журнале Ricerca Scientifica. В это время Nature как раз становился главным научным изданием планеты, замещая в этой роли Naturwissenschaften увлекшейся строительством тысячелетнего Рейха Германии. Но британский журнал был солидно неспешен. А для Ферми скорость публикации – которую обеспечивала Ricerca Scientifica – была важнее всего.

А потом, когда перспективы деления урана стали уже ясны, ученые разных стран всерьез рассматривали введение добровольной самоцензуры на публикации по ядерной тематике. Еврейских эмигрантов из Европы, прежде всего Лео Сциларда, пугала перспектива обретения нацистами ядерной бомбы, а их германские коллеги опасались гонки вооружений. Тогда этого добиться не удалось – публикации по урановой тематике остановила лишь начавшаяся Вторая мировая, оставившая публике лишь популярные публикации, вроде The Miracle of U-235

И вот сегодня, в эпоху информационную, когда публикации об интереснейших разработках в области ИТ сменяют друг друга с необычайной скоростью, а опоздавший – опаздывает навсегда, мы можем наблюдать уникальное явление. Занимающаяся разработками дружественного людям искусственного интеллекта бесприбыльная компания OpenAI, приверженность которой принципам открытого кода видна из ее названия, вдруг продемонстрировала крайнюю осторожность в публикации своих результатов. Что же заставило ее так поступить?

Задуматься о самоцензуре заставила ее совершенно безобидная, на первая взгляд, разработка –система natural language processing (NLP), работы с естественными языками, на нейронной модели GPT-2, достаточно подробно описанная в статье Language Models are Unsupervised Multitask Learners. Это нейросеть с 1,5 миллиардами параметров, натренированная на массиве текста в сорок гигабайт, позаимствованного с восьми миллионов общедоступных сайтов. Одна из «умных машин», построенных с целью общаться естественном языке, без программирования гигантского массива грамматических правил. Так, как говорят по-русски те, кто никогда не видел книжек Розенталя.

Обратим внимание – нейронная модель GPT-2 не является программой на языке вроде LISP PROLOG, в процедуры которой включены нормы естественного языка и обеспечен доступ к словарям в соответствии с теми и иными правилами. Это – интеллектуальная tabula rasa, модель «идеального ученика», который не знает ничего, но при работе с тем или иным набором данных приобретает способность повторять действия, позволяющие порождать сходные данные. Ну, как дети в традиционных обществах учились говорить, не заучивая таблицы падежей и склонений, а всего лишь копируя речь окружающих.

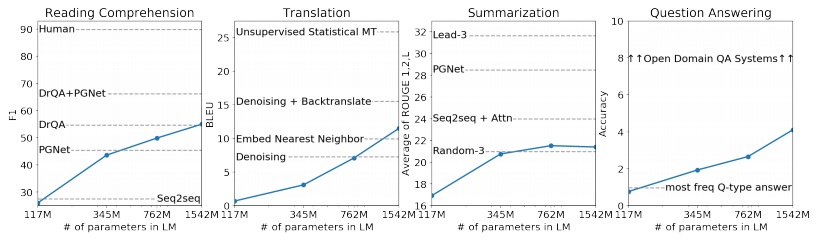

В данном случае брался набор тестовых данных, известный под названием WebText; гигабайты текстов на естественном – в данном случае английском – языке, взятых с миллионов реальных интернет-страниц. И обрабатывая их нейросеть обучалась понимать прочитанное, переводить, отвечать на вопросы и подводить итоги. Как мы видим из картинки выше – чем больше был модели, тем выше оказывалось качество работы с естественным языком. Ну, как большинство детей бессмысленно учить читать года в четыре – когда еще не проросли в нужном количестве нейроны с синапсами, являющиеся прототипом нейросети. Ну а когда это происходит – печатное слово усваивается легко.

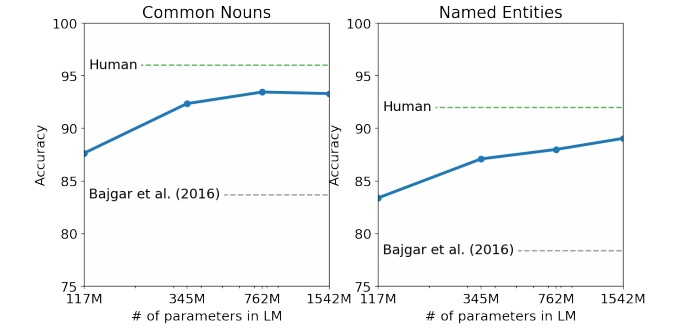

Кстати, один из тестов, созданных для проверки качества обучения нейросети, так и называется – Children’s Book Test, Тест детских книг. В него входит и классическая «Книга джунглей» Редьярда Киплинга – русскоязычные дети книжной эпохи знали ее преимущественно по многократно издававшимся переводам рассказов про Маугли Нины Дарузес (сделавшим леопарда Bagheera самкой пантеры Багирой…). Тест детских книг проверяет и понимание имен собственных, и способность к пониманию тоже зависит от размера нейросети. Ну, как детские книги адресовались определенному возрасту…

Так вот, работающая с естественным языком нейронная модель GPT-2 продемонстрировала весьма неплохие способности к пониманию текста, ответам на вопросы и подведению итогов, суммаризации. Ее испытали в написании рецензий на продукты, продаваемые Amazon – рецензии получились вполне на уровне написанных людьми. (Подробнее о результатах испытания нейронной модели можно прочитать в OpenAI let us try its state—of—the—art NLP text generator…) Ну а журналисты Gardian смогли убедиться, как бойко киберписатель включается в обсуждение проблем Брексита.

Но дальше произошло самое интересное – создатели системы, приверженность которых принципам открытости кода ясна из самого имени организации OpenAI, приняли необычное решение – воздержаться от публикации кода киберписателя (New AI fake text generator may be too dangerous to release, say creators.) Воздержаться не из корысти – а из соображений общественной безопасности (…keeping technologies private when there are safety concerns), изначально декларированных в концепции OpenAI.

Но чем же опасен киберписатель? Как его можно сравнивать с весомыми, грубыми, зримыми последствиями деления тяжелых ядер и синтеза ядер легких? Для ответа на этот вопрос заглянем в публикацию немецкого журнала Focus – Evolutionär verankert: Wie das Smartphone unsere Beziehungen beeinflusst. Там описывается, что по мнению аризонского исследователя Сбарры зависимость современных людей от гаджетов и соцсетей имеет глубокие эволюционные корни. Человек, для того чтобы выжить, нуждался в поддержке ближних и стремился поддерживать с ними постоянный контакт. Телекоммуникации смяли пространство – и теперь ближними стали те, с кем общаешься через смартфон, никогда их не видев. А теперь представим, что этот «ближний» есть бот на нейронной модели GPT-2.

Ну, коммерческие последствия очевидны (вспомним рецензии на продукты Amazon) – киберписатель забьет соцсети негативными или хвалебными, но достаточно убедительными, отзывами на продукты, которые никогда не держал в отсутствующих у него руках. А могут быть и последствия общесоциальные. Вот, например, хорошо известный приказ (executive order) президента Трампа о введении санкций в случае хакерского вмешательства в электоральные процессы США – Trump to target foreign meddling in U.S. elections with sanctions order. Признается факт попыток хакеров повлиять на выборы – и запускается механизм санкций в адрес той или иной страны. Фактически – устанавливается предвоенное состояние.

А хакерство ведь сейчас рассматривается не обязательно как «взлом» машин для голосования. Это и таргетирование политрекламы по примеру Cambridge Analytica. Это и работа стад ботов. Ну а киберписатель способен неутомимо, с тактовой частотой много выше, чем у белковых троллей, забить соцсети своими кратенькими текстами. Кратенькими, но ловко составленными. В националистические паблики с ультранационалистической повесткой. В либеральные – со сверхлиберальной. Надо лишь потренировать нейросеть на соответствующих наборах данных. Проблем с совестью у нейросети не будет – это не личность.

И – даже не универсальный искусственный интеллект. Это – вычлененные, перенесенные в кремний и гипертрофированные навыки составления текстов. Достаточно ловко моделирующих речь той или иной сетевой тусовки – «Звери спят и только йожег продолжает аццкий отжиг…». Заставляющих признать киберписателя «своим», и за счет эволюционных механизмов сделать распространяемые им идеи близкими и понятными. И это – конец демократических механизмов современного, бесцензового, вида; массовый избиратель не отягощен образованием и ,не имея опыта управления собственным хозяйством, склонен верить популистской демагогии любого сорта.

Агитаторы-клиенты исстари толклись на Форуме перед выборами в центуриатных комициях, агитируя за патронов. Но достучатся до сельских избирателей они не могли – те удалены, да и не верят незнакомцам… А тут телекоммуникации сжали мир; и киберписатель с легкостью предстает «своим». Публикация кода GPT-2, ранее обычная для OpenAI, даст «фабрикам троллей» по всему миру уникальный инструмент влияния… Поэтому-то эта публикация и была отложена – изначально на полгода – до углубленного изучения последствий. Но это лишь временная отсрочка – возможность такой технологии уже продемонстрирована, как бомба Gadget явила миру реальность ядерного оружия.

То есть – вычлененные и перенесенные в кремний навыки «интеллектуальной» работы уже готовы менять мир. Например – в активном маркетинге, в рекламе. Когда-то физики с риском для жизни устанавливали критическую массу – GPT-2 показала, что «критическая масса» пишущей нейросети это миллиарды параметров. В отличие от ядерного оружия – которое, относясь к технологиям индустриальной эпохи, требовало гигантской концентрации производственных мощностей для создания – ИскИн невозможно ограничить соглашениями о нераспространении. Про него можно только знать и учитывать это знание в своем поведении, начиная от покупок и кончая выборами.