EMC и NetApp – пионеры рынка СХД

Направим свой взгляд в сторону одного из лидеров на рынке современных Систем Хранения Данных — EMC, которая лично у меня ассоциируется со стратегической дальнозоркостью, и которая внесла весьма ощутимый вклад в развитие технологий хранения данных. Первым примером прозорливости, в хорошем смысле этого слова, был выпуск экономичной памяти на полупроводниках взамен дорогой ферритовой и именно на этом сегменте была сконцентрирована EMC вплоть до доклада из Беркли о создании первых дисковых массивов (RAID) в 1987 году. Руководство компании, тонко чувствуя потребности рынка и вектор его движения, тут же направили все свои усилия на полупустующую нишу носителей и дисковых систем и заняли в этом сегменте крепкую позицию, не упуская её и в наши дни.

Руководство EMC в то время лучше других понимало, что “кадры решают всё” и во всю использовали тактику “покупки” лучших инженерных умов везде, где это было возможных. Не пожалели они даже кампанию IBM, активно переманивая лучших специалистов к себе в штат. Так произошло и с Моше Янаи (Moshe Yanai), которого не упустил зоркий взгляд корпорации. Впоследствии Моше вместе со своей командой разработал концепцию кеширования (Integrated Cached Disk Array), которая применяется по сей день.

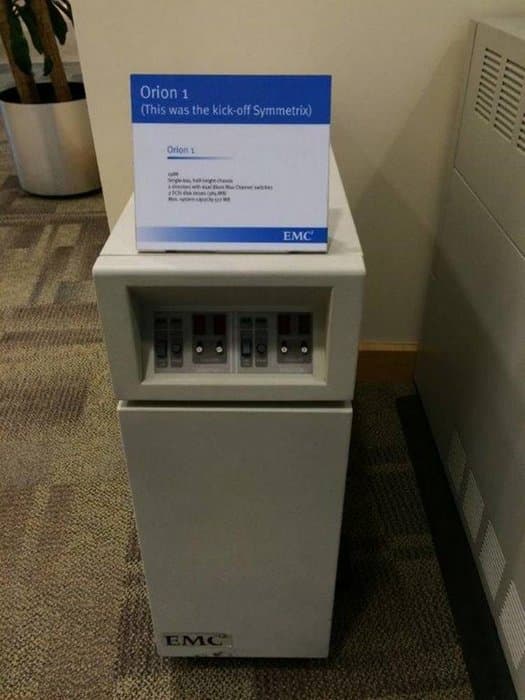

В итоге в 1988 году компания EMC создаёт свою первую систему хранения данных Orion 1, по своему принципу являющейся DAS (Direct-attached storage) и подключающуюся к мейнфреймов (а именно на них были направлены силы EMC) с помощью интерфейса SCSI. Её особенностью было использование под полезный объём хранения всё тех же полупроводниковых плат памяти (эдакий all-flash из 80х), что накладывало большие ограничения на суммарное дисковое пространство (512MB), что и являлось, по сути, провалом данного продукта. Но полупроводники были на голову производительнее механических “блинов”, что и натолкнуло на замечательную мысль использовать данную концепцию как кэш-память к массиву из относительно дешёвых жёстких дисков и в 1990 году на сцену выходит Symmetrix 4200 с capacity 24GB и кэшем 256MB, что и позволило занять нишу подобных решений для мейнфреймов и на много лет опередить своих конкурентов.

Примерно в это же время, после откола части инженеров от вышеупомянутой Auspex, в 1992 году, Дэвид Хитц (David Hitz), Джеймс Лау (James Lau) и Майкл Малькольм (Michael Malcolm) образовывают компанию NetApp, которая в отличие от большинства своих конкурентов была изначально нацелена и до сих пор профильтруется исключительно на создании Систем Хранения Данных.

Они создают NetApp filer, полноценный Network Attached Storage, так же известный как FAS — NetApp Fabric Attached Storage. Идея была в том, чтобы создать универсальное устройство, способное работать как с NFS, так и с CIFS (SMB), а также поддерживать предоставление пространства на блочном уровне через команды SCSI. При таком подходе не удивительно, что подобные устройства поддерживали FTP и HTTP и являлись уже тогда, по сути, готовыми (и относительно недорогими) appliance для предоставления общего доступа к файлам по широкому спектру протоколов. Уже это выводило системы хранения данных на новый уровень. Но это далеко не единственное достижение NetApp. Организация хранения информации в их системах основана на системе WAFL, на которой стоит немного остановиться.

Изначально инженеры NetApp планировали использовать уже существующую на тот момент файловую систему Berkeley FFS, а так как их идея изначально состояла в создании единой системы на множестве дисков, превращая любое их количество в единое пространство хранения, то ввиду конструктивных особенностей FFS, от неё пришлось отказаться. Она так же не давала прозрачности при работе с блочным уровнем пространства, ведь работала поверх RAID, без которого обойтись ввиду понятных причин никто в серьёзной системе не мог. Так родилась WAFL — Write Anywhere File Layout (Пишем везде), которая организовывала свой собственный уровень RAID, полностью получая контроль над размещением информации на носителях. Данная концепция столь же проста, сколько гениальна. При изменении блока файла NetApp не стал идти классическим путем и считывать этот блок для дальнейшей замены, он просто сказал, что теперь вся измененная информация будет записываться в свободный от данных блок, что колоссально сокращает нагрузку на систему хранения данных, уменьшая количество операций, производимых при записи или изменении файлов.

Преимущества NetApp — это программный рейд + WAFL, скорость на запись такого рейд сравнима со скоростью записи RAID10 (но при этом без потери половины полезного объема), за счет записи данных в свободные блоки, плюс журналирование, позволяющее поддерживать консистентное состояние файловой системы в случае сбоев.

Такая организация размещения данных не навела ещё вас на ту же мысль, которая родилась у инженеров NetApp более двух десятилетий назад? Правильно. Снэпшоты. Пока у нас достаточно свободного места, мы можем создавать снимки ВСЕЙ системы и читать любой файл из сохраненного состояния просто скопировав root inode, в котором записана структура на данный момент времени.

Данные концепции компания NetApp пронесла сквозь время и до наших дней, прочно укрепившись на лидирующих позициях наряду с EMC.

Нужно понимать, ЧТО в середине 90х из себя представлял мир информационных технологий. Компьютеризация дошла до домов рядовых пользователей, а компьютер в том или ином виде хоть и не перестал быть роскошью, но стал доступен простому обывателю. Всё большее число компаний открывало для себя сеть интернет: кто для простого продвижения своего продукта, а кто и для выстраивания своей бизнес-модели на просторах глобальной паутины. Так появилось понятия “Бум доткомов”, так же известный как “Пузырь доткомов”, когда в середине 90х годов началась настоящая истерия на фоне использования сети интернет для ведения бизнеса. Акции интернет-компаний баснословно взлетали, чтобы в начале 00х камнем рухнуть вниз, что привело к массовым арестам и банкротству сотен компаний.

Но данный феномен сыграл и некую положительную роль — он предал импульс и так динамичному в то время миру информационных технологий. Строились ЦОДы, которые нуждались во всех больших объёмах для хранения информации, а также удобству доступа к ней и скорости её передачи. Системы хранения вначале стали насыщать крупный enterprise, а со временем стали доступны и в сегментах среднего и малого бизнеса.

Компания Hewlett Packard создаёт первый на рынке rackmounted сервер — Proliant 4000 в 1993 году, а после утверждения Американским национальным институтом стандартов (ANSI) в 1995ом технологии Fibre Channel мир пришёл к популярной до сих пор трёхуровневой архитектуре построения инфраструктуры, состоящей из трёх независимых компонентов: серверов, систем хранения данных и сетевой составляющей. Конвергенция в данном вопросе придёт к нам несколько позже.

Дальше эволюция пошла достаточно плавно. Все фундаментальные технологии были разработаны и постепенно модифицировались. Каналы выдавали бОльшую пропускную способность, носители получали увеличенную емкость, процессоры становились быстрее, а глобальная сеть проникла практически в каждый дом. Но так было до 2006 года, когда Amazon не создала первое облако под названием EC2.

Эпоха виртуализации

На сегодняшний день виртуализация стала понятием обыденным, ведь только ленивый не пробовал превращать свой настольный компьютер в настоящую платформу для виртуализации. Про провайдеров различных облачных услуг и упоминать не стоит, наоборот, редко сейчас где встретится standalone сервер, ведь на сегодняшний день подобная утилизация производственных мощностей кажется нелепой, да и удобство развертывания и обслуживания стоят далеко не на последнем месте.

Сейчас трудно представить себе, что первая платформа виртуализации появилась в середине 1960х годов в лабораториях корпорации IBM. Это был, по сути, гипервизор CP-40, которая позволяла запускать до 14 независимых операционных систем в разделённом пространстве одного мейнфрейма. Тогда это был настоящий переворот в вопросе многозадачности компьютеров середины 20 века.

Развитие данного подхода не останавливались и в последующие годы, но настоящий прорыв в этом плане произошёл на стыке 90х и 00х годов, а во главе этого прорыва стояла всем известная компания VMWare. Основанная в 1998 году, уже через год она выпускает первый продукт для виртуализации на платформе x86 — Vmware Virtual Platform, а ещё через два года — гипервизор ESX.

С этих моментов требования к Системам Хранения Данных начали изменяться ввиду новых реалий — повсеместного использования виртуализации и необходимости хранений данных виртуальных машин, обеспечения отказоустойчивости и их доступности. Следующим подобным изменением станет появление облачных технологий, которые ознаменуют новую эру информационных систем.

Облака

Если не брать 70ые годы, когда первый раз был использован знак облака как выхода за приделы локальных систем на просторы ArpaNet, то первым, кто вышел на рынок, неся над головой гордо поднятый флаг с изображением облака, была компания Amazon со своим сервисом EC2 в 2006 году. Amazon представляли необходимые потребителю мощности по модели pay-as-you-go (плати когда используешь). Так же было предложено хранилище информации S3. После Amazon этот флаг с небольшим отрывом подхватили компании Google, Microsoft, IBM и SUN. Облачная эра началась.

К этому моменту мир информационных технологий уже созрел для того, чтобы менять парадигмы “приземлённости” своих структур и был готов для перехода на новое понятие — Услуга. Инфраструктура-как-услуга, Софт-как-услуга, Платформа-как-услуга, телефония, любое приложения и любые сервисы можно предоставлять как услугу без необходимости выстраивать под них собственную дорогостоящую инфраструктуру, мирясь с издержками на её внедрение и дальнейшее обслуживание, а прозрачность cash-flow делало данную возможность по истине привлекательной для владельцев бизнеса.

Качество предоставления услуг облачных провайдеров возрастало параллельно с совершенствованием используемых технологий. Сейчас мы можем получить полностью готовую к использованию инфраструктуру практически мгновенно больше не заботясь о том, что купленное оборудование устареет, а новой надо внедрять и обслуживать.

Как эти изменения повлияли на Системы Хранения Данных? Стало строиться огромное количество Центров Обработки Данных, образовываться провайдеры, предлагающие облачные услуги в том или ином виде, поэтому рост потребности в СХД был неизбежен. На рынок начали выходить конвергентные и гиперконвергентные системы и хоть классический SAN в те времена и имел львиную долю всех систем хранения, но на лицо был рост унифицированных продуктов с возможностью универсального доступа к данным, а необходимость в более гибких программно-определяемых системах только увеличилась (привет от NetApp из 1992 года).

Потребности из количественных переросли в качественные, скорости передачи и обработки данных росли, а на фоне этого роста всё острее стоял вопрос об увеличении производительности самих систем хранения данных. Этот вопрос частично был решён выходом на рынок систем хранения с SSD-носителями. Начиналась история твердотельных накопителей в далёких 70х с появлением первых полупроводниковых модулей памяти, но лишь в 1984 году, компанией Toshiba был представлен первый флэш-накопитель, а 5тью годами позднее из лабораторий этой же компании выходит первый NAND.

Лишь в 2004 году появляется 2.5” SATA SSD диск от компании Adtron Corporation. Дальнейшее развитие событий шло в сторону наращивания плотности хранения, увеличения скорости доступа к информации, а главное — в сторону удешевления цены за гигабайт, пока доступность SSD дисков максимально не приблизилась к классическим HDD. После выхода интерфейса SATA 3.0 в 2008, продемонстрировавший скорость передачи равной 6 Гбит/с, вопрос развития SSD стал актуальным как никогда. Вначале быстрые SSD использовали, по большому счёту, как хранилище для кэша, в то время как сам массив хранения располагался на HDD-массивах, но со временем цена за SSD стала более разумной и на рынке стали появляться первые All-flash решения. К 2016 году, когда, по сути, проблема износа ячеек была практически решена и All-flash максимально близко приблизились по доле к системам хранения с HHD на борту.

Так как выглядит собирательный образ современной Системы Хранения Данных? Сейчас уже никто не удивляется, получая от IaaS-провайдера услуги, полностью расположенные на быстрых SSD. Развитие технологий позволяет получать эти услуги всё дешевле, функции дедупликации дают возможность существенно наращивать плотность хранения, современные системы легко масштабируются практически без влияния на расширяемый сегмент. Отказоустойчивость и доступность систем вышли на уровень, позволяющий организовать в разумных пределах отработку огромного количества отказов, а современные скорости передачи данных позволяют забыть о таком понятии, как расстояние.

Внедрение и обслуживание современных Систем Хранения Данных максимально упрощены, конвергентность инфраструктур как облачных провайдеров, так и локальных развёртываний позволяют максимально сократить издержки на поддержку данных систем, что так же позволяет снизить цену на предоставляемые услуги.

Заключение

Так к чему мы стремимся и как будут выглядеть системы хранения в ближайшем и не очень будущем? Зная ответ на подобные вопросы компании, которые в данный момент находятся в лидирующих позициях магического квадрата Gartner, в своё время приходили к успеху.

Инструмент всегда подбирается исходя из поставленных задач, события редко опережают время, а технологии крайне зависимы друг от друга и развиваются параллельно. Мог ли инженер, создающий в 1954 году диск размером с гараж и ёмкостью в 3.5 мегабайта, представить, что когда-нибудь носитель, превышающий его по ёмкости в сотни тысяч раз, будет помещаться в кармане его брюк? Или думали мы в 90х, что когда-то одним кликом мыши будем делать моментальные снимки десятков терабайт данных и таким же простым движением к нему возвращаться? Поэтому можно сказать только одно — через 10-20 лет, как сейчас на дискеты, мы так же будем смотреть на существующие технологии и называть их динозаврами из прошлого.

Корпоративный блог компании NetApp, Inc. — лидера на рынке дисковых систем хранения данных и решений для хранения и управления информацией.